Dernières nouvelles du cosmos

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

De Tout et de Rien

sous- titre :

" Parce qu'il n'y a pas que les chevaux et les courses dans la vie... "

et le sujet ouvert actuellement , où , précisément trônent 2 vidéos de chevaux s'appelle , lui :

" dernières nouvelles du cosmos ..."

on y traite de l'univers pas des chevaux ;

merci d'ouvrir un sujet ou de poster ces vidéos dans une rubrique adéquate ...

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Japon : un collisionneur géant pour percer les mystères de l’Univers

De nombreux collisionneurs ont vu le jour durant ces dernières années dont le LHC, grand collisionneur de hadrons, le LEP, collisionneurs électron-positron ou encore le KEKB, le VEPP-2000 et le VEPP-4 construits a l’Institut de physique nucléaire Budker. Plus récemment, les scientifiques se sont concentrés sur la conception du SuperKEKB, un collisionneur géant japonais auquel les Russes ont contribué.

Il sera le premier collisionneur depuis 2008 à traiter du mystère de l’antimatière. La première collision d’électrons et de positrons du SuperKEKB a eu lieu dernièrement au centre international KEK, dans la ville de Tsukuba, Japon. Les évènements qui ont eu lieu durant cette première expérience ont été enregistrés par le détecteur Belle II.

Actuellement, les chercheurs se concentrent sur l’augmentation de la fréquence des collisions entre la matière et l’antimatière et le SuperKEKB leur sera d’une grande aide.

Un collisionneur qui offre de grandes possibilités

Le SuperKEKB aidera les scientifiques à enregistrer les collisions extrêmement rares de particules élémentaires avec une précision jamais atteinte auparavant a expliqué Konstanin Belotski de l’Institut d’ingénierie physique de Moscou lors d’une interview accordée à des médias locaux.

« Cette possibilité d’étudier les particules à un niveau technologique aussi élevé est vraiment incroyable, car il est très difficile en général de contrôler les particules. Le collisionneur japonais SuperKEKB, dont les éléments les plus importants ont été créés avec la participation de physiciens russes nous permettra d’observer et d’étudier tous ces processus plus en détail. »

Découvrir les mystères de l’Univers

Toujours d’après Konstanin Belotski, ce collisionneur permettra aux scientifiques de se rapprocher de nouveaux mystères des lois physiques qui se caractérisent par des symétries spéciales, susceptibles toutefois d’être perturbées. Les expériences qui seront menées grâce au SuperKEKB permettront essentiellement de trouver de nouvelles particules jusqu’alors inconnues de tous.

Elles aideront aussi à connaitre les causes de la domination de la matière sur l’antimatière que nous observons dans l’Univers. « L’étude de ce processus est d’une immense signification fondamentale pour la science. Nous savons que la symétrie, c’est une loi de la nature, mais il s’avère qu’elle a été violée. Il se peut que cela ait joué un rôle déterminant dans l’apparition de notre Univers. »

Konstanin Belotski n’a pas mentionné quand est ce que ces expériences débuteront et combien de temps elles dureront.

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Première mondiale: des protons qui avancent en crabe

Le CERN a testé avec succès des « cavités-crabe », cavités dont la fonction est de modifier l'orientation des paquets de protons dans le faisceau - une première mondiale. Le test s'est déroulé le 23 mai, avec un faisceau du Supersynchrotron à protons (SPS) du CERN. Il a montré que les paquets de protons pouvaient être inclinés au moyen de ces cavités radiofréquence supraconductrices générant un champ transverse. Celles-ci sont des pièces essentielles pour le LHC à haute luminosité (HL-LHC), la future version améliorée du LHC

Le HL-LHC, qui sera mis en service après 2025, fera augmenter la luminosité du LHC d'un facteur de cinq à dix. La luminosité est un indicateur clé de la performance d'un collisionneur : elle donne le nombre de collisions potentielles par unité de surface sur une période de temps donnée. En d'autres termes, plus la luminosité est élevée, plus les collisions sont nombreuses, et donc plus les expériences peuvent enregistrer de données. Cette luminosité plus élevée permettra aux scientifiques d'observer des processus rares dont la détection exige un niveau de sensibilité dépassant la portée actuelle du LHC. Les physiciens seront ainsi également en mesure de réaliser des études de précision sur les nouvelles particules observées dans le LHC, comme le boson de Higgs. Pour cette augmentation de la luminosité, les cavités-crabe nouvellement développées auront un rôle important à jouer.

Les deux faisceaux qui circulent en sens opposés dans le LHC ne sont pas constitués d'un flux ininterrompu de particules, mais de « paquets » de protons de quelques centimètres de long, qui contiennent chacun des milliards de protons. Ces paquets se rencontrent, avec un petit angle de croisement, à chaque point de collision, au coeur des expériences. Une fois qu'elles seront installées en amont et en aval des expériences ATLAS et CMS, les cavités-crabe « inclineront » les paquets de protons de chaque faisceau, de manière à maximiser leur zone de recoupement au point de collision. De cette manière, chaque proton contenu dans le paquet sera forcé de passer à travers toute la longueur du paquet opposé, ce qui augmente la probabilité des collisions, et donc la luminosité. Une fois inclinés, les paquets de protons semblent se déplacer latéralement - comme le ferait un crabe. Des cavités-crabe ont déjà été utilisées dans le collisionneur KEKB au Japon, avec des électrons et des positons, mais jamais avec des protons, qui sont plus massifs et atteignent des énergies largement plus élevées. « Les cavités-crabe sont censées augmenter la luminosité, dans l'ensemble, de 15 à 20 % », indique Rama Calaga, qui dirige le projet des cavités-crabe.

Les deux premiers prototypes de cavités-crabe ont été fabriqués au CERN en 2017, en collaboration avec l'Université de Lancaster et le STFC (Science and Technology Facilities Council) au Royaume-Uni, ainsi qu'avec le programme LARP (LHC Accelerator Research Program) aux États-Unis. Les cavités ont été assemblées dans un cryostat, puis testées, au CERN. Composées d'un matériau supraconducteur en niobium d'une grande pureté, elles fonctionnent à 2 kelvins (-271 °C) et génèrent un voltage transverse très élevé, de 3,4 millions de volts. Les cavités ont été installées dans l'accélérateur SPS pendant le dernier arrêt technique hivernal afin de subir des tests de validation avec des faisceaux de protons.

Les premiers tests avec faisceaux, qui ont eu lieu le 23 mai, ont duré plus de cinq heures. Ils se sont déroulés à une température de 4,2 K, avec un unique paquet de protons accéléré à 26 GeV et contenant entre 20 et 80 milliards de protons, ce qui correspond presque à l'intensité des paquets du LHC. Les cavités-crabe ont été mises sous tension à environ 10 % de leur voltage nominal. La « progression en crabe » a été suivie au moyen d'un moniteur spécial, permettant d'observer l'inclinaison sur toute la longueur du paquet. « Ces tests marquent le début du fonctionnement d'une installation exceptionnelle pour le test des cavités supraconductrices avec un faisceau de protons de haute énergie et un courant élevé, explique Lucio Rossi, chef du projet HL-LHC. Les résultats sont impressionnants et cruciaux pour prouver qu'il est faisable d'utiliser ces cavités pour faire augmenter la luminosité dans le LHC. »

Dans les mois à venir, les cavités seront mises en service à leur voltage nominal de 3,4 millions de volts, et elles subiront une série de tests afin de valider entièrement leur fonctionnement en vue de l'ère du HL-LHC. Au total, 16 cavités-crabe seront installées dans le HL-LHC : huit à proximité d'ATLAS et huit à proximité de CMS.

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

4 juin 2018

Une mesure inédite révèle l’affinité du boson de Higgs avec le quark top

Après la découverte du boson de Higgs en 2012, une nouvelle étape majeure vient d’être franchie au LHC dans la compréhension du mécanisme qui confère une masse aux particules élémentaires. Les résultats des expériences ATLAS et CMS, compatibles entre eux et présentés aujourd’hui lors de la conférence LHC Physics à Bologne, confirment la forte interaction entre la particule élémentaire de matière la plus lourde, le quark top, et le boson de Higgs. Cette mesure, inédite jusqu’à ce jour, qui a été menée avec de nombreux scientifiques français des laboratoires de l’IN2P3 (CNRS et universités) et de l’Irfu (CEA), ouvre des pistes pour la recherche de nouvelles physique.

Étudier le boson de Higgs et débusquer la nouvelle physique...

En physique des particules, deux types de stratégies sont utilisées pour débusquer la nouvelle physique. Soit on teste un modèle théorique en cherchant ses manifestations, par exemple à travers la découverte de nouvelles particules, soit on essaie de mettre en défaut le modèle existant. C’est ici la deuxième approche qui est exploitée. Le Modèle standard de la physique des particules ne prédit par la force d’interaction (ou « couplage ») entre les différentes particules, notamment entre le boson de Higgs et le quark top. Ce couplage entre deux particules lourdes n’avait encore jamais été mesuré et ce nouveau résultat permet un bond en avant dans notre connaissance des propriétés du boson de Higgs. Ce faisant, il ouvre la voie vers des tests encore plus contraignants pour le Modèle standard. En effet, des particules lourdes révélatrices d’une nouvelle physique, jusque-là jamais observées, pourraient elles aussi participer à ce type de désintégration.

La communauté française à la pointe pour ce défi scientifique

Cette recherche est l’une des plus difficiles jamais conduites par les scientifiques d’ATLAS et CMS car seulement 1% des bosons de Higgs sont produits en association avec deux quarks top. C’est à dire qu’il faut faire plus de 150 milliards de collisions de protons pour produire un seul événement de ce type ! Pour y arriver, il a donc fallu accumuler suffisamment de données à une énergie de collision proton-proton puis prendre en compte tous les d’états finaux possibles et utiliser les méthodes les plus avancées de traitement de données par réseaux d’apprentissage (Machine Learning). Dans les deux expériences, le résultat annoncé aujourd’hui est le fruit d’une stratégie étagée exploitant les données collectées à des énergies de 7, 8 et 13 TeV. Les équipes d’ATLAS et de CMS ont mené plusieurs études indépendantes pour traquer ce processus appelé « production ttH », chacune axée sur un mode de désintégration différent du boson de Higgs (désintégration en bosons W , bosons Z, photons, leptons taus et jets issus des quarks bottom). Pour augmenter le plus possible la sensibilité au signal ttH, très difficile à observer expérimentalement, chaque expérience a ensuite combiné les résultats de toutes ses recherches grâce à des méthodes statistiques avancées. L’interprétation fine des collisions s’appuie sur leur excellente maîtrise des détecteurs que les ingénieur·es et instrumentalistes français·es ont contribué à concevoir et construire. Les chercheurs et chercheuses du CNRS, du CEA et des universités ont joué un rôle majeur dans de nombreux « étages » de cette analyse, menée en collaboration avec les physicien·nes théoricien·nes et les informaticien·nes français·es.

La combinaison de l’ensemble de ces mesures a conduit à l’observation de la production ttH avec une sensibilité statistique supérieure, pour les deux expériences prises séparément, au seuil de 5 écarts standards traditionnellement requis pour une découverte. Cela signifie que si la production ttH n’existait en fait pas, l’expérience avait au plus environ une chance sur 3,5 millions de l’observer malgré tout par erreur.

Ces prochaines années, les deux expériences collecteront bien plus de données et amélioreront la précision de ce couplage afin de déterminer si le Higgs révèle la présence d’une physique au-delà du Modèle standard

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Un Univers sans matière noire?

On pourrait résoudre d’un coup la double énigme de la matière noire et de l’énergie noire en admettant qu’il reste dans notre Univers de l’antimatière et qu’elle possède une masse négative. Une hypothèse audacieuse, mais qui devrait être bientôt testée. Les explications dans cet article paru dans le numéro 4 de la revue «Carnets de science».

Un peu plus d’un siècle après qu’Einstein a débarrassé la physique de l’hypothèse qu’une substance inconnue, l’éther, remplissait l’Espace, l’astrophysique et la cosmologie sont à nouveau confrontées à une curieuse énigme : notre Univers serait rempli à 95 % d’une matière noire et d’une énergie noire dont nul n’a su jusqu’ici expliquer ni l’origine ni la nature. Accepter l’existence d’un secteur sombre aussi envahissant qu’insaisissable reste pour une majorité de physiciens le moyen le plus évident de rendre compatibles l’ensemble des données astrophysiques à leur disposition et la théorie de la relativité générale. Seulement voilà : après quarante ans de traque intensive, aucun instrument ni aucune expérience n’ont permis d’observer la moindre structure cosmique ou la moindre particule pouvant endosser le rôle de cette masse invisible.

Sans parler de crise, cette situation est très frustrante pour une discipline dont l’objectif est d’aboutir à une théorie décrivant exhaustivement le contenu de notre Univers et son évolution. Le physicien Gabriel Chardin, qui a reçu la médaille d’argent du CNRS en 2007 pour ses travaux sur la matière noire, notamment au sein de la collaboration internationale Edelweiss[1], pense qu’il serait possible d’en sortir en envisageant, comme Einstein en son temps, un nouvel accroc au sens commun : accepter qu’il existe des masses négatives dans notre Univers, tout comme il existe des charges électriques positives et négatives. À partir de là, il envisage un nouveau modèle cosmologique avec un Univers comportant autant de matière que d’antimatière, où il n’est plus nécessaire de faire appel aux concepts de matière ou d’énergie noire. « Cet Univers, développé depuis dix ans avec Aurélien Benoit-Lévy, est encore très loin d’être accepté comme une alternative au modèle standard cosmologique, avec matière noire et énergie noire, reconnaît Gabriel Chardin, qui développe en détail ses idées dans l’essai L’Insoutenable gravité de l’Univers. Mais il ne repose pas que sur des spéculations, il reproduit de façon assez étonnante un grand nombre de données dont on dispose et fait des prédictions qui pourront être testées dans les prochaines années, voire les prochains mois. »

Des anomalies dans la Chevelure de Bérénice

Mais pour quelles raisons la communauté scientifique en est-elle venue à considérer comme nécessaire l’existence d’un secteur sombre ? Et quelles sont celles qui poussent aujourd’hui un nombre croissant de chercheurs à envisager des hypothèses alternatives ? Le premier à avoir soulevé, dès 1933, l’hypothèse d’une masse invisible est l’astrophysicien suisse Fritz Zwicky (1898-1974). En observant la Chevelure de Bérénice, où il mesurait les vitesses des galaxies qui orbitent dans l’amas du Coma, il calcula que la gravité exercée par la matière visible ne pouvait pas compenser la force centrifuge qui s’exerçait sur ces galaxies : elles auraient dû être expulsées de l’amas comme d’un manège tournant trop vite. Il en déduisit la présence d’une matière obscure, dont la masse était bien plus importante que celle de la matière visible. Il s’écoula plus de trente ans avant que son intuition soit confirmée par l’étude que Vera Rubin mena sur les profils de rotation à l’intérieur des galaxies. Le seul moyen d’expliquer ce profil dans le cadre des lois de la gravité était d’admettre que ces galaxies étaient plongées dans un halo de matière noire six fois plus lourd que leur contenu visible. Ces résultats ont ensuite été confirmés et de nombreuses autres observations indépendantes ont accumulé les indices en faveur de l’existence d’une matière noire. Quoique concordants, ces différents indices n’en sont pas moins indirects. D’autant qu’aucune des formes de matière sombre connues (planètes, neutrinos, trous noirs) ne semblant pouvoir contribuer significativement à cet excès de masse, la matière noire ne peut relever que d’une physique encore inconnue.

Modifier les lois de la gravité

Cette matière, ou les mystérieuses particules qui la composent, des physiciens du monde entier les traquent donc depuis quarante ans, soit dans l’Espace, soit dans des accélérateurs comme le LHC, soit à l’aide de détecteurs de plus en plus sensibles. L’ennui est qu’ils n’ont jusque-là rien découvert. Ce qui permet certes aux théoriciens de contraindre un peu plus les caractéristiques possibles de cette matière exotique, mais suscite aussi de plus en plus de doutes quant à son existence. Dès 1983, le physicien israélien Mordehai Milgrom s’est rendu compte qu’il n’y aurait plus du tout besoin d’invoquer la moindre matière noire… à condition de modifier les lois de la gravité newtonienne. Notant que ces lois n’ont en fait été testées et vérifiées que dans les champs gravitationnels relativement forts de notre Système solaire, il propose de les remanier lorsqu’elles s’appliquent aux corps évoluant dans des champs très faibles, ceux qui règnent dans l’Espace intersidéral.

« Cette théorie, baptisée Mond (Modified Newtonian Dynamics), prédit bien le profil des vitesses dans les galaxies. Le problème est qu’à ce stade on ne dispose d’aucun moyen de la tester expérimentalement, note Gabriel Chardin qui est par ailleurs président du Comité des très grandes infrastructures de recherche au CNRS. L’engin le plus éloigné de nous, la sonde Voyager, est soumis à un champ gravitationnel cent millions de fois plus faible que celui auquel il était soumis à la surface de la Terre, mais c’est encore mille fois plus fort que ce à quoi il serait soumis dans des champs dits “faibles” ! »

Faute de cette preuve expérimentale, la majorité des chercheurs hésitent à remettre en question des lois qui, depuis Einstein, n’ont jamais été mises en défaut. D’autant que si Mond peut nous débarrasser de la matière noire, cette théorie est de toute façon incapable de répondre à une nouvelle énigme posée par la gravité : la découverte en 1998 de l’accélération de l’expansion de l’Univers, interprétée comme la manifestation d’une sorte de gravité répulsive.

Comme la nature de ce phénomène mystérieux restait inexpliquée, les physiciens l’ont traité comme la matière noire : ils l’ont rajouté à la liste de leurs « inconnus connus » et en ont mesuré les effets. Ils ont appelé énergie noire cette nouvelle composante mystérieuse. Les mesures du satellite Planck indiquent que cette énergie noire représente aujourd’hui un peu plus des deux tiers de l’énergie contenue dans l’Univers, la matière noire environ un quart et la matière connue à peine un vingtième. En acceptant cette curieuse composition, les cosmologistes ont pu élaborer le modèle standard cosmologique. Un modèle qui, tout en restant compatible avec la relativité générale et les observations, s’efforce de décrire de manière cohérente l’histoire de l’Univers du Big Bang à nos jours.

De l’antimatière dans le vide intergalactique ?

« S’il reste la solution de référence pour la majorité des physiciens, à mon sens comme dans l’esprit d’un nombre croissant de mes collègues, le modèle standard cosmologique possède plusieurs aspects très inélégants, nuance Gabriel Chardin. Il marche assez bien, c’est vrai, mais il apparaît de moins en moins vraisemblable dans sa composition, et compte un trop grand nombre de paramètres libres, qu’il faut réajuster à chaque nouvelle observation. Bref, quelque chose cloche dans l’Univers qu’il décrit… » Et c’est pour cette raison que de nouveaux modèles ont récemment été proposés par des théoriciens comme André Maeder, de l’université de Genève, ou Thomas Buchert, du Centre de recherche astrophysique de Lyon[2] : des Univers n’ayant besoin ni d’énergie noire, ni de matière noire pour expliquer les observations actuelles.

C’est également le cas de l’Univers de Dirac-Milne élaboré par Gabriel Chardin. Celui-ci le fait reposer sur deux hypothèses révolutionnaires. Il considère d’abord que cet Univers contient autant de matière que d’antimatière, et que l’antimatière possède une masse gravitationnelle négative. « La disparition totale, du moins apparente, de l’antimatière de notre Univers demeure à ce jour un autre des grands mystères du modèle standard : celui-ci indique pourtant que l’Univers comprenait pendant ses tout premiers instants après le Big Bang autant de matière que d’antimatière, insiste-t-il. Dans l’Univers de Dirac-Milne, plus besoin d’expliquer la disparition de l’antimatière : elle est toujours là, cachée dans les vides intergalactiques. » La supposition que l’antimatière possède une masse négative est une supposition plausible, car, à ce jour, aucune expérience n’a pu mesurer la masse de l’antimatière. « À l’échelle atomique, si on le compare à l’électromagnétisme ou à l’énergie cinétique des particules, l’effet de la gravité est négligeable, explique le physicien. On sait produire depuis plus de vingt ans des atomes d’antihydrogène, mais on vient tout juste de trouver le moyen de les ralentir suffisamment pour pouvoir bientôt les peser. » (Lire l’encadré ci-dessous.)

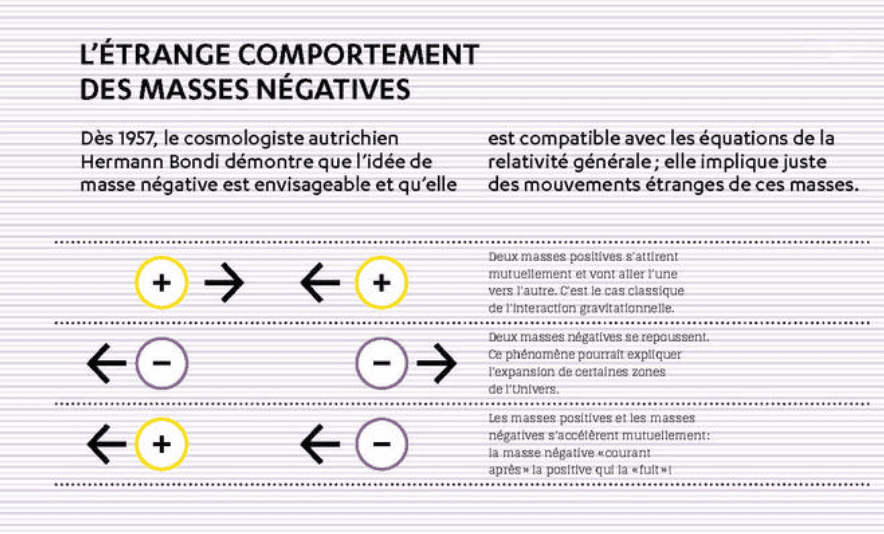

Des masses négatives dans l’Univers ?

Les théoriciens ont en tout cas démontré que l’existence de masses négatives est parfaitement compatible avec la relativité générale, même si les mouvements qu’auraient ces masses les unes par rapport aux autres sont très étranges : tandis que les masses positives s’agrègent entre elles, les masses négatives se repoussent et s’écartent les unes des autres! « Dans un tel Univers, sous l’effet de la gravité, la matière – de masse positive – s’agrège et forme de grandes structures. En revanche, les particules d’antimatière, de masse négative, s’étalent en gaz froid dans ce que nous prenons pour de grands vides cosmiques. » Des vides qui, en s’étalant, et en repoussant les structures de masse positive, expliqueraient, sans avoir besoin d’énergie noire, l’expansion de l’Univers telle qu’elle est observée.

Par ailleurs, le fait de supposer qu’existent des particules de masse positive comme négative a un autre effet inattendu : il crée une polarisation du vide qui modifie les équations de la gravité. Celles-ci présentent alors une grande similarité avec celles de la théorie Mond. On peut dès lors se passer de l’hypothèse de la matière noire pour expliquer la rotation des galaxies. « En l’état, le modèle d’Univers de Dirac-Milne reste hautement spéculatif, mais les valeurs auxquelles il aboutit sont étonnamment proches de celles déjà mesurées par les grands programmes d’observation, et il va être directement testé dans les prochaines années, voire peut-être dès la fin de l’année 2018, grâce aux expériences Gbar, Alpha-g et AEgIS au Cern, qui vont enfin mesurer la masse gravitationnelle de l’antimatière, assure Gabriel Chardin. Nous saurons alors si l’explication proposée d’un Univers matière-antimatière, guidée par ses arguments d’élégance mathématique et physique, est bien confirmée par l’expérience. » ♦

___________________________________________

Peser l’antimatière : lourde tâche !

L’antimatière posséderait une masse négative et se comporterait différemment de la matière quand elle est soumise à la gravité. Cette hypothèse, proposée par le physicien Gabriel Chardin, est plausible, mais très audacieuse. Car si l’on maîtrise désormais assez bien la production d’antiprotons dans les accélérateurs, « peser » ces antiparticules chargées négativement est presque impossible tant l’effet de la gravité est négligeable par rapport à celui de l’interaction électromagnétique. Un moyen de neutraliser cette force consiste à créer des atomes neutres d’antihydrogène en combinant un antiproton et un positron (anti-électron). La difficulté est alors de parvenir à confiner et ralentir ces anti-atomes avant qu’ils rencontrent des atomes de matière et qu’ils s’annihilent. En utilisant un piège magnétique, la collaboration Alpha du Cern est parvenue récemment à confiner pendant plusieurs heures un millier d’antihydrogènes. D’ici à la fin de l’année, Alpha va tenter de déterminer ce qui se passe exactement quand on « lâche » ces anti-atomes dans un champ gravitationnel. À suivre…

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Les travaux de construction d'un nouveau LHC ont débuté. Celui-ci produira des faisceaux de protons plus intenses pour des collisions plus riches en évènements rares. Ce LHC à haute luminosité, ou HL-LHC, devrait partir chasser de la nouvelle physique à l'horizon 2025-2026.

www.futura-sciences.com/sciences/actuali...ur-lhc-debute-60356/

Avec ses détecteurs géants et sa connexion à une grille mondiale d'ordinateurs, le LHC est sans doute l'objet technologique le plus avancé créé par l'humanité. Lorsque ce Grand collisionneur de hadrons est enfin parti à la chasse à de la nouvelle physique, en 2010, les physiciens des hautes énergies étaient très majoritairement optimistes.

Ils s'attendaient à mettre en évidence rapidement des particules supersymétriques, dont certaines devaient être la clé de la nature de la matière noire. Il était même raisonnable d'obtenir tout aussi rapidement des preuves de la validité de la théorie des cordes, que ce soit avec la mise en évidence d'un boson Z' ou, mieux encore, avec la mise en évidence de minitrous noirs de Hawking s'évaporant en un éclair après leur création.

Il n'en fut rien, mais le LHC a tout de même atteint son but principal initial, à savoir la mise en évidence du fameux boson de Brout-Englert-Higgs (BEH) en 2012. Les chercheurs ont pu également vérifier depuis avec plus de précisions certaines prédictions du modèle standard de la physique des hautes énergies et commencer à explorer l'origine des masses des quarks et des leptons formant la matière en montrant que, là aussi, intervenait la physique du boson de BEH via les fameux couplages de Yukawa.

Une théorie standard triomphante, hélas…

Les résultats ont été finalement, jusqu'à présent, à la fois triomphants et désastreux. Lors de l'hommage rendu à Pierre Binétruy, hélas décédé, Jean Iliopoulos a argumenté, avec raison, pour que l'on parle désormais de la théorie standard plutôt que du modèle standard après la découverte du boson de BEH et la précision des mesures confirmant sa validité. C'est donc un triomphe spectaculaire. Mais, pour le moment, c'est aussi potentiellement un désastre car nous n'avons toujours pas la moindre indication d'une nouvelle physique dans les résultats des mesures concernant les produits des collisions de protons au LHC. Pire, le triomphe de la théorie standard pourrait indiquer qu'il est à tout jamais hors de portée de la technologie humaine de mettre en évidence directement cette nouvelle physique car nous ne seront jamais capable de construire des accélérateurs assez puissants pour cela (ils pourraient devoir être de la taille de la Voie lactée).

Tout espoir n'est cependant pas perdu. Il est en effet possible d'améliorer encore la précision de ces mesures mais, pour cela, il faut augmenter le nombre de collisions afin de « faire grimper la statistique », comme disent les physiciens dans leur jargon. Pour obtenir cette augmentation du nombre de collisions en un temps raisonnable, et pas au bout d'un siècle par exemple, il faut faire augmenter ce que l'on appelle « la luminosité des faisceaux de protons ».

Il est facile de comprendre pourquoi en comparant la situation à la problématique de la formation d'une bonne image avec un appareil photo. Il est nécessaire de faire entrer rapidement suffisamment de lumière pour éviter un temps de pause trop long et, tout simplement, pour avoir assez de photons afin d'obtenir une image assez détaillée et, ainsi, pouvoir identifier ce qu'elle représente et avoir des détails.

Des faisceaux de protons 5 à 7 fois plus lumineux avec le HL-LHC

C'est pourquoi, depuis des années, les ingénieurs et physiciens du Cern étaient engagés dans la conception d'un LHC à haute luminosité (HL-LHC) permettant de passer d'environ un milliard de collisions proton-proton par seconde à 5, voire 7 milliards de collisions par seconde, ce qui devrait permettre d'accumuler environ 10 fois plus de données entre 2026 et 2036, au moment où le HL-LHC partira à son tour à la chasse à de la nouvelle physique.

Or, le laboratoire européen vient de faire savoir dans un communiqué que les travaux de génie civil pour le HL-LHC avaient commencé. Ceux-ci permettront d'installer dans des tunnels et des halls souterrains de nouveaux équipements cryogéniques et systèmes d'alimentation électrique associés à de nouveaux et nombreux composants de haute technologie tels que des aimants supraconducteurs et des cavités radiofréquences. L'objectif est notamment de se servir d'environ 130 nouveaux aimants pour comprimer les paquets de protons, et, donc, augmenter la luminosité des faisceaux.

Comme l'a dit Fabiola Gianotti, directrice générale du Cern, « le LHC à haute luminosité étendra la portée du LHC au-delà de sa mission initiale, apportant de nouvelles opportunités de découvertes, de mesurer avec plus grande précision les propriétés de particules comme le boson de Higgs et de sonder encore plus profondément les constituants fondamentaux de l'univers ». Espérons qu'il permettra de valider la théorie de la supersymétrie, voire de découvrir que les particules de matière sont en fait composées de rishons.

www.futura-sciences.com/sciences/actuali...ormant-quarks-25421/

Les physiciens de la collaboration Atlas viennent de publier un article portant sur la recherche d'une possible structure composite des quarks. Le détecteur géant du LHC n'en a pour le moment vu aucune mais il a fourni de nouvelles limites pour des théories comme celle des rishons de Haim Harari.

Il y a peu de temps, les physiciens de la collaboration CMS annonçaient avoir découvert un phénomène intriguant, et pour le moment inexpliqué, dans les collisions de protons à 7 TeV ayant lieu au LHC. Son cousin, le détecteur Atlas, n'a lui rien observé de nouveau mais, paradoxalement, cette absence d'information nous renseigne sur ce que n'est pas une possible physique au-delà du modèle standard.

On sait que la luminosité des faisceaux de proton au LHC est un paramètre clé pour espérer faire de la nouvelle physique. Les réactions de production de particules nouvelles prédites par des théories au-delà du modèle standard sont si peu probables qu'il est vital de disposer d'un nombre important de collisions par seconde pour espérer découvrir en quelques années seulement qu'il existe bel et bien des particules supersymétriques, ou le fameux boson de Higgs par exemple.

Dans l'état actuel des faisceaux au LHC, la luminosité, c'est-à-dire en gros une mesure du flux de particules dans les faisceaux, est encore bien faible mais quelques signaux d'une nouvelle physique peuvent déjà être recherchés. C'est ainsi qu'Atlas a pu être utilisé pour poser les meilleurs bornes à ce jour sur une structure composite des quarks.

Dans le jargon du domaine, les physiciens des particules élémentaires ont cherché des résonnances indiquant l'existence d'un quark q*, c'est-à-dire un état excité lourd des 6 saveurs de quarks contenues dans le modèle standard. Une résonnance se manifeste en gros sous la forme d'une bosse dans une courbe donnant la probabilité de production d'une réaction entre particules élémentaires en fonction d'une énergie.

Des particules plus élémentaires que les quarks et les électrons

Il y a plus de 30 ans, le physicien Haim Harari avait proposé une théorie dans laquelle les différents quarks et leptons (comme l'électron et les neutrinos) étaient tous des états composites de seulement deux particules véritablement élémentaires : les rishons. Cela semblait naturel car il est désagréable que des particules de matière dites fondamentales soient au nombre de 12.

Le mot rishon signifie « primaires » en hébreu. Il y a donc un rishon T, de l'anglais third, car il a une charge électrique de 1/3 e, ou encore Tohu qui signifie « informe » en hébreu et un rishon V de l'anglais vanishes (« disparaît »), car il est électriquement neutre, ou vohu qui signifie « vide », toujours dans la Genèse en hébreu.

Tous les leptons et toutes les saveurs de quarks sont ensuite classés en trois triplets de rishons. Ces groupes de trois rishons ont un spin 1/2 comme il se doit pour un fermion. On a ainsi par exemple :

•TTT = antiélectron ;

•VVV = neutrino électronique ;

•TTV, TVT et VTT = trois couleurs de quarks up ;

•TVV, VTV et VVT = trois couleurs d'antiquarks down.

Chaque rishon ayant bien sûr une antiparticule correspondante.

De la même façon que les atomes peuvent posséder différents états d'énergies et donc différentes masses quand ils sont excités, les quarks du modèle standard devaient pouvoir être portés à des niveaux d'énergies plus élevés si on les fait entrer en collision à suffisamment hautes énergies. Tout comme les atomes retombant dans leur état fondamental en émettant des photons, ces états excités devraient être instables et un quark q* doit redevenir rapidement un quark q ordinaire en émettant des particules.

Une limite sur les masses des quarks excités

Dans le cas des expériences d'Atlas, si quelque chose comme la théorie des rishons d'Harari, ou plus généralement une théorie avec des préons constituant les quarks était exacte, on devait pouvoir observer deux jets d'hadrons opposés (on parle de dijet) bien particuliers. Des caractéristiques de ces jets, il est alors relativement facile de remonter à la masse du quark émetteur. Si ce dernier était bien un état excité q*, il devait apparaître comme plus lourd.

Des recherches précédentes de ce genre ont déjà été faites, en particulier au Tevatron américain, mais grâce à Atlas, on sait maintenant que la bande d'énergie 0,30 TeV - 1,26 TeV est exclue pour les masses d'un quark q*. Rappelons que la masse la plus lourde pour un quark est celle du quark top estimée à 170,9 ± 1,8 GeV. Les théories viables avec des préons composant leptons et quarks devront maintenant tenir compte de ces bornes.

Sinon, comme toujours, on peut suivre l'état des faisceaux au LHC en direct. Dans peu de temps, ce sont des ions lourds pour des expériences dans le détecteur Alice qui vont remplacer les protons pour les collisions.

Connexion ou Créer un compte pour participer à la conversation.

- ivct

-

Auteur du sujet

Auteur du sujet

- Hors Ligne

- Groupe I

-

- Messages : 10418

- Remerciements reçus 9217

Réponse de ivct sur le sujet Dernières nouvelles du cosmos

Connexion ou Créer un compte pour participer à la conversation.